El SEO, críptico acrónimo muy

utilizado en la red, como si diese más categoría a los técnicos

especializados en esta nueva disciplina de la información utilizar

estos vocablos que no entienden los usuarios normales en vez de su

definición en español, no es más que la aplicación de una serie

de ajustes en los sitios webs para que los motores de búsqueda

puedan encontrar más fácilmente sus contenidos e “interpretarlos”,

es decir, categorizarlos de tal forma que sean mostrados enlaces a

estas webs a los usuarios cuando estos buscan información en los

buscadores de Internet empleando una serie de palabras clave.

Y la realidad de Internet es que,

aunque hablamos de motores de búsqueda en genérico, y de vez en

cuando aparecen buscadores que destacan por la introducción de algún

aspecto novedoso (el respeto del anonimato en la web, la

especialización en un segmento de información, o en una determinada

región geográfica, etc) lo cierto es que el buscador por excelencia

es Google, y todo hay que decirlo, por méritos propios. Así que en

un porcentaje altísimo de casos, cuando hablamos de SEO, deberíamos

hablar de GSEO (Google Search Engine Optimization).

El propio Google, para facilitar a los

creadores de contenidos que éstos estén optimizados para que su

buscador encuentre sus creaciones y las procese adecuadamente, y

dicho sea de paso, para que los propios creadores del contenido

trabajen un poco para él, y conseguir que su motor de búsqueda (y

no el de los demás) sea el que mejor procese estos contenidos, y así

ofrezca resultados de mayor calidad a los usuarios del buscador, ha

publicado una guía de optimización para motores de búsquedas para

principiantes.

“La optimización para motores de

búsqueda consiste a menudo en pequeñas modificaciones de partes concretas de tu sitio web.

Cuando estas modificaciones se consideran de manera individual, pueden percibirse como mejoras, pero

cuando se combinan con otras optimizaciones, podrían causar un gran

impacto en la experiencia del usuario y en el rendimiento del sitio

en los resultados de búsqueda orgánicos.”

Y en un mundo ideal, en el que los

productores de contenidos lo hacen pensando únicamente en este

contenido, y en los destinatarios de los mismos, el proceso de

creación y descubrimiento más lógico sería que los productores

crean contenidos, a lo sumando teniendo en cuenta algunos principios

básicos para facilitar su trabajo a los motores de búsqueda, pues

es natural que todo creador aspire llegar al mayor público posible,

y los motores de búsqueda aprenden a categorizarlos, de tal forma que

dirijan a los usuarios que buscan información a los mejores

contenidos en función de sus intereses.

Pero como

vivimos en una sociedad que tiende a la especulación, en la que por

ejemplo la economía financiera, de la inversión en futuros, cortos

y largos, multiplica por cinco la economía productiva,

los SEO han

estudiado técnicas que, a partir del conocimiento de cómo funcionan

los robots de los motores de búsqueda que indexan y categorizan el

contenido de la web, permitan que páginas o recursos con contenido

menos relevante para los “consumidores humanos”, sean

interpretadas por los motores de búsquedas como más relevantes que

otros recursos que si tienen ese interés.

Este fenómeno ha derivado

en que Internet se ha ido llenando poco a poco de “basura espacial”

(símil que me parece muy ilustrativo del fenómeno, al igual que

todos los satélites ya no operativos que se encuentran orbitando el

planeta Tierra), con gran número de contenidos irrelevantes, o

plagiados, y que han ido adelantando en los primeros lugares de

resultados del Buscador a los contenidos originales o de gran

relevancia para sus usuarios humanos.

Para definir estos lugares se

ha introducido un nuevo término:

“splog”:

"blog

creado con el único fin de promocionar sitios

web afiliados, mejorar la posición de los mismos ante los

buscadores, para

publicar únicamente avisos publicitarios que pagan por cantidad de

visitantes. El contenido de estos blogs es generalmente texto escrito

específicamente para obtener mayores ganancias con AdSense

o también textos copiados desde otros sitios web. Los splogs se han

convertido en un problema mayor en los servicios de alojamiento

gratuito de blogs, como el servicio Blogger

de Google. Se

estima que allí, tres de cada cinco blogs son en realidad splogs.[1]

Estos blogs falsos desperdician espacio en los discos

duros y ancho

de banda así como también contaminan los resultados de los

buscadores en Internet,

perjudicando especialmente a los buscadores especializados en blogs".

Logo del proyecto "Splog Project" (http://splogproject.com/) para combatir el Splog.

El buscador de Google utiliza el algoritmo

PageRank,

que es muy vulnerable al abuso de enlaces para asociar un término

con un sitio web,e specialmente cuando estos aparecen en sitios con un

indice de PageRank alto. Los splogs pueden convertirse en un

obstáculo para las personas que buscan información en los blogs. A

veces, los splogs escogen un nombre similar al de un blog de buena

reputación para confundir al visitante casual.

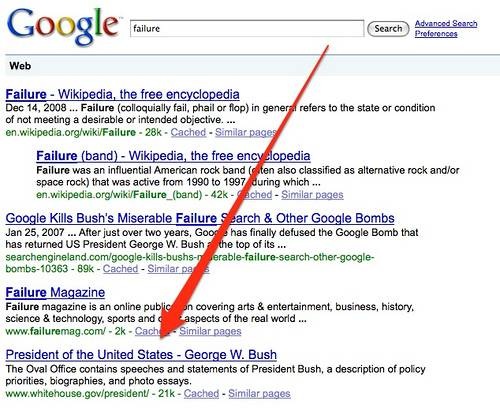

El extremo de esta práctica sería el

concepto conocido como “

Google bombs” (una traducción libre

sería “atentados en Google”, que a mi me gusta más que la

literal “Bombas Google”), por el que unos “terroristas del

buscador”, haciendo uso de las técnicas SEO comentadas con

anterioridad, pueden h

acer que determinados sitios web o contenidos

digitales aparezcan como los más relevantes en búsquedas que usan

palabras clave cuya asociación con la empresa u organización que

publica este contenido pueda generar una degradación de su imagen

pública.

Así, navegando un poco por la red podemos encontrar

célebres “atentados en Google” (enlace:

http://www.searchenginepeople.com/blog/incredible-google-bombs.html

) como la asociación de enfermedades venéreas al fenómeno fan

Justin Biever, la aparición de la web de Microsoft como primer

resultado de la búsqueda “more evil than Satan”, o la asociación

de términos de búsqueda de connotaciones muy peyorativas (ruina,

fracaso, mentiroso, etc) a las figuras de presidentes del gobierno de

grandes naciones como Sarkozy, Blair o George W. Bush.

Google Bomb que asoció la palabra clave "liar" (mentiroso) a la biografía del ex-primer ministro británico Tony Blair.

Caso de Google Bomb similar al anterior. En este caso la palabra clave fue "failure" y el afectado George W. Bush.

Y puesto que Google no se puede

permitir este fenómeno, que haría que su buscador dejase de tener

utilidad como localizador de la información de calidad que

justamente está buscando el usuario, con todo lo que eso

conllevaría, en pérdida de cuota de usuarios, a los que monitorizar

sus hábitos de consumo a través de cookies, y a los que mostrar

continuamente publicidad segmentada en función de estos hábitos, el

gigante de Internet está continuamente optimizando y mejorando los

algoritmos de sus robots de indexación y categorización de

contenido, lo que hace que, de todas las innumerables prácticas y

recetas que recomiendan los expertos en SEO, de las que está la web

llena, solo unas pocas, las prácticas más razonables, y que en mi

opinión están relacionadas con facilitar el trabajo del buscador, e

incluso también del propio consumidor humano de los contenidos

creados, siguen siendo de utilidad, mientras que aquellas que

“tratan de engañar al buscador”, haciendo parecer relevante un

contenido que realmente no lo es, son rápidamente inocuas, pudiendo

incluso llegar a provocar el efecto contrario: que el buscador

penalice estos lugares web que hacen uso de estas técnicas.

De todas las innumerables prácticas y

recetas que recomiendan los expertos en SEO, de las que está la web

llena, solo unas pocas, las prácticas más razonables, y que en mi

opinión están relacionadas con facilitar el trabajo del buscador, e

incluso también del propio consumidor humano de los contenidos

creados, siguen siendo de utilidad, mientras que aquellas que

“tratan de engañar al buscador”, haciendo parecer relevante un

contenido que realmente no lo es, son rápidamente inocuas, pudiendo

incluso llegar a provocar el efecto contrario: que el buscador

penalice estos lugares web que hacen uso de estas técnicas.

Sin duda, aquellos

que han hecho de su actividad profesional el posicionamiento de

páginas web en buscadores podrán tildar de radical esta afirmación,

y podrán demostrarme con numerosos ejemplos de su trabajo diario

cómo aplicando recetas y trucos, bien de cosecha propia bien

procedentes de otras fuentes, y que rápidamente se propagan por el

propio carácter viral de las redes de intereses comunes, han

conseguido posicionar en los primeros lugares de los resultados de

búsqueda y para una serie de palabras clave una web que, por la

relevancia de su contenido en principio tendría que estar en

posiciones más retrasadas.

En mi humilde opinión, esto es “pan

para hoy y hambre para mañana”. Los buscadores en general, y

Google en particular, no quieren “dejarse engañar”, aunque lo

vistan en la Guía de como un beneficio para tus usuarios:

Aunque en el

título de esta guía aparezcan las palabras "motores de

búsqueda", nos gustaría decir que, ante todo,

debes basar tus decisiones sobre optimización pensando en la mejor

opción para los usuarios que

visitan tu sitio. Son los principales consumidores de tu contenido y

utilizan motores de búsqueda para

encontrarlo. Si te centras demasiado en determinados ajustes para

obtener un buen posicionamiento

en los resultados de búsqueda orgánicos, no podrás ofrecer los

resultados deseados. La

optimización para motores de búsqueda trata de mostrar lo mejor de

tu sitio en los motores de

búsqueda.

En futuras entradas de este blog iremos publicando aquellas prácticas SEO que sí me parecen útiles y razonables.